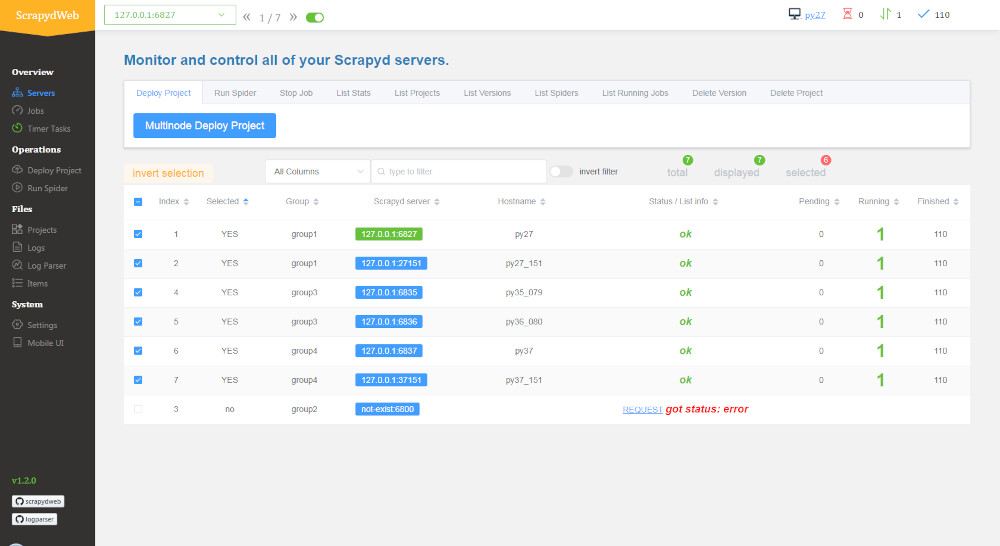

Приложение ScrapydWeb для парсинга Python

Если вы не хотите связываться с облаком zyte, то вам подойдёт приложение ScrapydWeb для запуска пасинга. Оно выглядит как сайт и устанавливается как библиотека. Вам нужно купить несколько серверов. Как минимум 2. Если хотите сэкнономить, то можно и одним VDS обойтись. Как только вы установите и настроите ScrapydWeb, то вы сможете запускать job'ы со спайдерами задачами.

Плюсы ScrapydWeb:

- Вам не нужно светить свои данные. Если вы парсите конфиденциальные, персональные данные, то это выход.

- Этот сервис всегда с вами и всегда работает, если хостер не упал.

- Если вы будете использовать zyte и ему подобные платформы, то вас могут отрезать от сервера из-за санкций.

- Вам достается почти полный функционал от zyte. Разумеется такие фишки как AI будут не доступны.

- Нет абонентской платы за тарифный план

Минусы ScrapydWeb:

- Нужен VDS. Нужно обладать навыками для настройки сервера и установки приложения.

- Нет крутых фишек как в платформе zyte. Нет AI, рабочего процесса n8n

- Вам придётся покупать IP-адреса proxy соединений для парсинга.

Подробнее о библиотеке ScrapydWeb читайте на официальной странице github

Библиотека ScrapydWeb сама по себе не предоставляет функционала для управления IP-адресами при парсинге. ScrapydWeb — это веб-интерфейс для управления задачами в системе Scrapyd, которую можно использовать для развертывания пауков Scrapy и управления ими. Однако Scrapyd и Scrapy могут использовать различные методы для работы с прокси-серверами и смены IP-адресов.

Для смены IP-адресов при парсинге в Scrapy, вам нужно воспользоваться следующими подходами:

1. Прокси: Вы можете настроить использование прокси-серверов в вашем проекте Scrapy. Установите нужные прокси и добавьте их в настройки вашего паука или проекта. Пример настройки прокси:

# settings.py

DOWNLOADER_MIDDLEWARES = {

'scrapy.downloadermiddlewares.httpproxy.HttpProxyMiddleware': 110,

'your_project_name.middlewares.ProxyMiddleware': 100,

}

HTTP_PROXY = 'http://your_proxy:port'

# middlewares.py

import random

class ProxyMiddleware:

def process_request(self, request, spider):

# Замените на свой список прокси

request.meta['proxy'] = random.choice([

'http://proxy1:port',

'http://proxy2:port',

# Добавьте другие прокси

])2. Rotating Proxies: Используйте библиотеки, такие как `scrapy-rotating-proxies` или `scrapy-proxies`, которые автоматически меняют прокси для каждого запроса.

3. Сервисы смены IP: Вы можете использовать специальные сервисы, предоставляющие прокси с возможностью автоматической смены IP-адресов, такие как ScraperAPI, Bright Data (ранее Luminati) и другие.

Чтобы интегрировать любой из этих методов в ваше приложение Scrapy, просто следуйте инструкциям по установке и настройке соответствующей библиотеки или метода.

Таким образом, ScrapydWeb не меняет IP-адреса сам по себе, но вы можете настроить свой проект Scrapy, чтобы использовать прокси-серверы и менять IP-адреса во время парсинга.